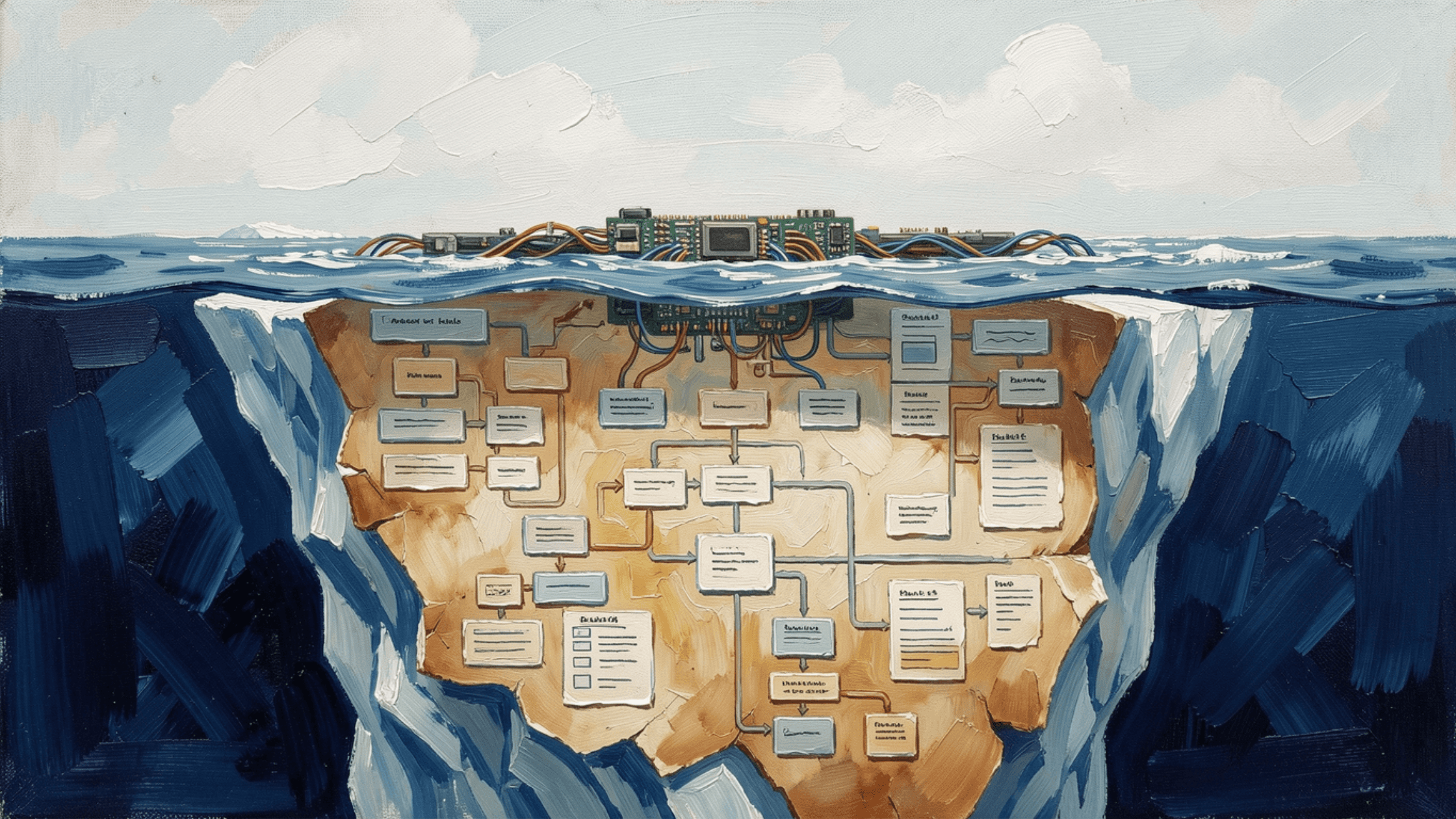

¿Alguna vez te has preguntado por qué ningún modelo de IA puede manejar perfectamente todas las tareas? 🤔

En Beam AI, estamos mejorando continuamente nuestros agentes de IA aprovechando las fortalezas de múltiples Modelos de Lenguaje Grande (LLMs) a través de nuestro enfoque innovador conocido como ModelMesh. Este método nos permite combinar dinámicamente modelos para satisfacer diversos casos de uso, asegurando que nuestras soluciones sean tanto confiables como rentables.

La Necesidad de una Estrategia Multi-Modelo

En la práctica, ningún modelo único sobresale en todas las tareas. Por lo tanto, empleamos una estrategia multi-modelo que equilibra precisión, rendimiento y costo. ModelMesh empodera a nuestros agentes de IA para seleccionar el modelo más efectivo, o la combinación de modelos, según los requisitos específicos de cada tarea.

Información Clave: Selección Dinámica de Modelos

ModelMesh integra varios LLMs y modelos privados, cambiando inteligentemente entre ellos en lugar de depender de una solución única. Por ejemplo:

GPT-4o: Mejor para razonamiento complejo y toma de decisiones, ideal para tareas que requieren comprensión profunda y análisis.

Claude 3.5: Confiable para el procesamiento y extracción de datos, asegurando que la información se recopile y presente con precisión.

Command R: Optimizado para flujos de trabajo de generación aumentada por recuperación (RAG), mejorando la capacidad de obtener datos relevantes rápidamente.

GPT-4o-mini: Ideal para tareas de baja latencia donde la velocidad es crítica, permitiendo respuestas rápidas sin pérdida significativa de precisión.

Modelos Privados (por ejemplo, Mistral): Ofrecen flexibilidad, privacidad y control para aplicaciones especializadas, atendiendo necesidades organizacionales únicas.

Equilibrios entre Rendimiento y Costo

Al combinar dinámicamente modelos, minimizamos el uso innecesario de recursos. Cuando es apropiado, nuestros agentes recurren a modelos más ligeros y rápidos, reduciendo la latencia mientras mantienen la calidad.

Diseño Escalable y Modular

ModelMesh está diseñado para escalabilidad y modularidad, permitiendo soporte plug-and-play de nuevos modelos. Esta flexibilidad nos permite integrar rápidamente innovaciones en el panorama de LLM sin estar confinados a una sola pila tecnológica.

Trae Tu Propio Modelo (BYOM)

Las organizaciones pueden integrar perfectamente sus modelos propietarios en ModelMesh, creando flujos de trabajo de IA altamente personalizados adaptados a sus necesidades específicas.

Aplicaciones en el Mundo Real

Un flujo de trabajo típico que utiliza ModelMesh podría incluir:

Command R iniciando tareas de recuperación en RAG.

Claude 3.5 procesando y limpiando datos para los pasos posteriores.

GPT-4o gestionando tareas de razonamiento complejo.

GPT-4o-mini asegurando respuestas rápidas cuando la velocidad es crítica.

Al optimizar nuestros agentes tanto para precisión como para eficiencia, estamos llevando al límite lo que es posible con flujos de trabajo de IA. ¡Estos son tiempos emocionantes en la ingeniería de IA, y esperamos aprender de otros que enfrentan desafíos similares con sistemas multi-modelo!